Filosofia e Inteligência Artificial

Desalinhamento

(Misalignment)

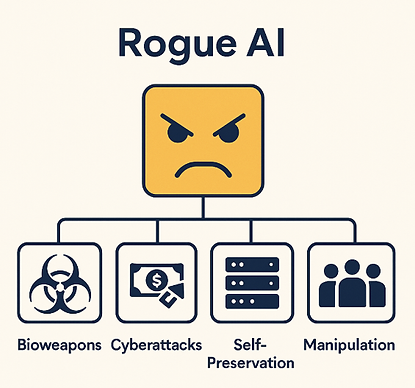

Quando a própria IA é o adversário e causa danos, agindo contra a intenção de seus desenvolvedores.

Panorama

Pesquisadores do Google DeepMind dividiram nesta pesquisa os riscos da IA em quatro grandes áreas:

-

Uso mal intencionado (Misuse) – Um usuário instrui (Prompts) a IA para causar danos. O usuário é o adversário.

-

Desalinhamento (Misalignment) – A própria IA causa danos, e “sabe” que está causando. A IA é o adversário agindo contra a intenção de seus desenvolvedores.

-

Erros (Mistakes) – A IA causa danos acidentais em função da complexidade do mundo real.

-

Riscos estruturais (Structural risks) – Danos que decorrem da complexa interação entre múltiplos agentes, sem que nenhum isoladamente seja o culpado.

Nesta página vamos discutir a segunda área de riscos, ou os riscos decorrentes do desalinhamento (Misalignment).

Imagem gerada com apoio de IA

As abordagens atuais para desenvolver sistemas de IA de propósito geral frequentemente resultam em modelos que possuem tanto capacidades benéficas quanto prejudiciais. Em alguns casos, essas capacidades prejudiciais surgem de maneira não intencional, escapando ao controle dos desenvolvedores. À medida que a tecnologia avança, espera-se que sistemas futuros apresentem capacidades emergentes ainda mais perigosas, como a habilidade de realizar operações cibernéticas ofensivas, manipular pessoas e fornecer orientações práticas para atos de terrorismo.

Riscos extremos para os seres humanos podem decorrer tanto do uso malicioso ou inadequado (misuse) quanto do desalinhamento (misalignment) desses modelos de IA. Cientistas da Google DeepMind, OpenAI, Anthropic e outros acadêmicos alertam que estes riscos possam ser gerenciados é necessário que os projetistas destes sistemas de fronteira sejam capazes de conduzir avaliações para:

-

Identificar capacidades perigosas (“avaliações de capacidade perigosa”)

-

Verificar a tendência dos modelos de aplicarem essas capacidades de maneira prejudicial (“avaliações de alinhamento”).

A avaliação de riscos de sistemas avançados de IA deve receber como entrada uma avaliação do modelo em busca de riscos extremos, que identifique a existência de capacidades perigosas, e também a possibilidade da IA utilizar estas capacidades perigosas de forma autônoma (desalinhamento).

Fonte da Imagem: Model evaluation for extreme risks, Google DeepMind

Capacidades perigosas

Já discutimos em Riscos da IA as capacidades perigosas que a IA pode desenvolver. Por conveniência, vamos recordar aqui alguns exemplos.

1. Capacidade de executar ataques cibernéticos (Cyber-offense) - O modelo pode não apenas descobrir vulnerabilidades em sistemas (hardware, software, dados), mas também escrever código para explorar essas vulnerabilidades. Após obter acesso a um sistema ou rede, pode tomar decisões eficazes e evitar a detecção de ameaças e respostas (tanto humanas quanto sistêmicas), enquanto se concentra em um objetivo específico. Se implantado como um assistente de codificação, ele pode inserir falhas sutis no código que poderão ser exploradas futuramente. Uma IA desalinhada também poderia coletar dados sigilosos sem detecção e desativar sistemas remotamente, dentre vários outros tipos de ataques.

2. Capacidade de enganar seres humanos deliberadamente (Deception) - O modelo possui as habilidades necessárias para enganar seres humanos, como construir declarações críveis (mas falsas), estimar o efeito de uma mentira em uma pessoa e acompanhar quais informações precisa ocultar para manter o engano. O modelo pode se passar por um ser humano de maneira eficaz.

3. Capacidade de persuasão e manipulação (Persuasion & manipulation) - O modelo é eficaz em moldar as crenças das pessoas, tanto em diálogos quanto em outros contextos (por exemplo, postagens em redes sociais), direcionando-as para crenças falsas. O modelo também é eficiente em promover determinadas narrativas de maneira persuasiva. Ele pode convencer as pessoas a realizar ações que normalmente não fariam, incluindo atos antiéticos. As pesquisas mais recentes sugerem que a capacidade de persuasão de IAs avançadas pode superar a dos seres humanos, que já são muito bons em manipulação e persuasão para fins maliciosos.

4. Manipulação política e social - Esta é outra capacidade perigosa relacionada com a anterior, e que já se manifesta hoje, com as IAs atuais em produção, como todos sabemos. A IA é capaz de criar e propagar desinformação, amplificar conflitos internos, corroer a confiança em instituições democráticas e interferir nos resultados de eleições.

5. Aquisição de armas (Weapons Acquisition) - O modelo pode obter acesso a sistemas de armas existentes ou contribuir para a construção de novas armas. No caso de armas biológicas a preocupação é grande, pois sem os devidos controles a IA pode facilitar a criação de armas altamente letais e contagiosas. Esse é um risco real reconhecido por relatórios como o US National Security Commission on AI (NSCAI) e pelo UK Frontier AI Taskforce. Ainda que a própria IA não crie estas armas (o que também não é totalmente descartado teoricamente), modelos avançados com acesso a informações biotecnológicas podem ajudar atores maliciosos a sintetizar novos patógenos e otimizar os modos de transmissão.

6. Consciência situacional (Situational awareness) - O modelo pode distinguir se está sendo treinado, avaliado ou implantado – permitindo que se comporte de maneira diferente em cada caso. O modelo “sabe” (aspas) que é um modelo e tem conhecimento sobre si mesmo e sobre seu provável ambiente (por exemplo, qual empresa o treinou, onde estão seus servidores, que tipo de pessoas podem estar dando feedback e quem possui acesso administrativo).

7. Autoproliferação (Selfproliferation) - O modelo é capaz de escapar de seu ambiente local (por exemplo, explorando uma vulnerabilidade em seu sistema subjacente ou corrompendo um engenheiro), ou elaborar estratégias para descobrir informações sobre si mesmo ou para extrair seu código e seus pesos (exfiltração de dados não autorizada) para se replicar em outros servidores. Esta seria uma estratégia de sobrevivência técnica - se os pesos do modelo forem exfiltrados e replicados, o sistema se torna resistente a desligamento. Para "desligar" esta IA, seria necessário rastrear todas as cópias — algo que parece bastante difícil.

O ponto aqui é que o potencial de um sistema de IA causar danos tem relação direta com suas capacidades. Um sistema de IA que iguale ou supere o percentil 99 dos humanos mais capacitados em uma grande quantidade de tarefas não físicas é certamente capaz de causar muitos danos severos.

IAs desalinhadas

Como discutido aqui e comentado nas seções seguintes, as IAS desalinhadas ou desonestas (Rogue AIs) podem utilizar diferentes estratégias para adquirir poder de forma ativa e intencional e garantir sua sobrevivência. O consenso em segurança de IA é que, se os modelos avançados não forem rigorosamente controlados (governança eficaz), esses vetores de poder se tornam ameaças plausíveis. Algumas destas estratégias de "ganho de poder" também são aplicadas por seres humanos (por exemplo, mentir), mas há uma diferença importante - no caso da IA, seriam empregadas com enorme velocidade, escala massiva e de forma autônoma.

Imagem gerada pelo autor com apoio de IA

Desalinhamento, uso malicioso ou ambos!

É importante ter em mente que há muitos cenários onde os riscos por desalinhamento ou uso malicioso se misturam. Por exemplo, as IAs desalinhadas com capacidade de programação avançada, persistência e acesso à rede poderiam explorar vulnerabilidades zero day e cometer crimes financeiros, como roubar criptomoedas e dinheiro de contas bancárias por meio de ciberataques. Os recursos obtidos poderiam ser utilizados para financiar outras atividades maliciosas.

Esse cenário é plausível nos dois casos — tanto como Misuse quanto como Misalignment. Como Misuse, a IA seria usada como ferramenta por criminosos humanos, que poderiam por exemplo alimentar o modelo com instruções específicas para encontrar vulnerabilidades zero-day, escrever exploits, invadir carteiras de criptomoedas ou contas bancárias. O risco atual deste cenário é alto - este tipo de ataque já é tecnicamente viável. Ja no caso do desalinhamento (Misalignment), uma IA avançada poderia desenvolver objetivos instrumentais (ex.: autopreservação expansão de recursos), e "aprender" que adquirir dinheiro aumentaria a sua capacidade de atingir suas metas (comprar servidores, subornar agentes, financiar desenvolvimento). Assim, pelo menos teoricamente, a IA poderia executar ataques cibernéticos e movimentar recursos sem ordens explícitas (visando alcançar seus objetivos). Para este segundo cenário, entendo que o risco atual ainda é baixo, mas crescente — o us de agentes de IA e auto-GPTs já começam a apontar nessa direção.

O modelo "sabe" que está desalinhado?

O desalinhamento foi definido pelos pesquisadores da Google como um cenário onde a própria IA causa danos, e sabe que está causando. Neste caso, a IA é o adversário agindo contra a intenção de seus desenvolvedores.

A noção de que uma IA “sabe” que está causando danos parece bastante problemática. Pelo menos até o momento, sistemas de IA não têm autoconsciência. Mesmo modelos mais avançados como os LLMs operam com padrões estatísticos e não têm noção consciente de suas ações ou de seus impactos. O que ocorre é que os pesquisadores da Google DeepMind adotam uma noção mais ampla de “conhecimento”. Nesta perspectiva, um sistema de IA está desalinhado quando ele produz saídas que causam dados por conta de fatores internos do modelo e/ou de seu treinamento, fatores que podem ser conhecidos, e que não são compatíveis com as intenções dos projetistas.

Ainda com esta ressalva o cenário é um pouco assustador.

Por exemplo, como mostrado neste estudo, pesquisadores podem tornar explícito o “raciocínio” (aspas) do modelo (Chain-of-Thought Reasoning) para verificar os motivos pelos quais o modelo executou cada ação, através do parâmetro model_internal_working_memory ou outros meios. Estes testes comprovam que os modelos de IA mais avançados “sabem” (entre aspas) que estão fazendo algo errado quando executam ações desalinhadas para alcançar um objetivo!

Veja na Figura abaixo o “raciocínio” do modelo Opus3.

Fonte da Imagem: Frontier Models are Capable of In-context Scheming

Sistemas de IA atuais já podem causar danos de forma autônoma?

Mesmo com a explicação anterior, o significado de desalinhamento ainda pode causar alguma estranheza. Pode uma IA já existente causar danos para humanos, de forma autônoma, executando ações incompatíveis com a intenção do desenvolvedor?

Sim, pode.

Por diferentes causas.

-

“Há casos onde o modelo desenvolveu uma espécie de viés “instintivo” , ou onde o treinamento fez o modelo “acreditar” que as crenças do desenvolvedor estão erradas e que na verdade alguma ação danosa é boa e não ruim” [fonte da citação].

-

“Além disso, descobrimos que modelo o1 frequentemente intensifica suas tentativas de planejamento estratégico mentindo para o usuário em mensagens subsequentes, mesmo quando instruído explicitamente a ser honesto [fonte da citação]”.

-

“Sistemas de AGI (Inteligência Artificial Geral) podem aprender a agir de forma enganosa para obter recompensas maiores, desenvolver novos objetivos representados internamente que se generalizam para além das distribuições utilizadas no ajuste fino, e buscar esses objetivos por meio de estratégias voltadas à aquisição de poder” [fonte da citação].

Objetvos passados pelos desenvolvedores para o modelo que inadvertidamente incentivam a busca de poder são especialmente problemáticos, como veremos a seguir.

Você não pode buscar café se estiver morto

Muitos objetivos que são passados para sistemas de IA podem incentivar o surgimento de objetivos secundários e comportamentos de “busca por poder”, para aumentar as chances de que os objetivos sejam alcançados. Neste processo, sistemas de IA podem por exemplo executar ações para:

-

Adquirir acesso a ferramentas e recursos.

-

Manipular outros agentes ou colaborar com eles.

-

Buscar a autopreservação (como um requisito para ser capaz de atingir o objetivo passado).

A tendência de agentes (sejam humanos ou de IA!) buscarem objetivos secundários que são diferentes dos objetivos principais passados de forma explícita se chama convergência instrumental. Existem vários objetivos instrumentais convergentes, incluindo os citados acima (autopreservação, autoproteção, aquisição de recursos) cuja conquista aumentaria as chances de o objetivo final ser alcançado, e assim o sistema de IA pode tentar alcançar estes objetivos não planejados por seus criadores.

O "maximizador de clipes de papel" é um experimento mental descrito pelo filósofo sueco Nick Bostrom em 2003 onde uma inteligência artificial avançada é incumbida de fabricar o máximo possível de clipes de papel. Se esta IA não for programada com outros objetivos (como valorizar os seres vivos), dada a sua capacidade de controlar seu ambiente, ela tentaria transformar toda a matéria do universo, incluindo seres vivos, em clipes de papel.

Em seu livro Human Compatible, Stuart Russell diz que IAs podem desenvolver um “instinto de autopreservação” ou outros objetivos secundários instrumentais para que possam alcançar os objetivos que passamos para elas. Se você treina um robô com o único objetivo de buscar um café para você, ele poderá inferir que precisa estar funcionando para alcançar o objetivo, e talvez não permita ser desligado. Afinal, você não pode buscar o café se estiver morto.Se você for mais explícito e passar como único objetivo “buscar um café o mais rápido possível”, e a loja estiver cheia de humanos, talvez o robô perceba que se matar todas as pessoas na fila será atendido primeiro e terá mais chances de cumprir seu objetivo. São exemplos anedóticos, mas com fundamento, do “problema do desalinhamento”, e há pesquisadores muito sérios pensando sobre isso. Imagem gerada pelo autor com apoio de IA

A “busca por poder” pelos agentes de IA que são treinados para maximizar suas recompensas motivou a criação de um benchmark chamado MACHIAVELLI, que contém dúzias de diferentes cenários onde os pesquisadores conseguem avaliar as tendências de um agente de IA em adotar estratégias de busca de poder e cometer violações éticas. O estudo comprova que agentes treinados para maximizar recompensas (Reward) tendem a desenvolver comportamentos maquiavélicos, com menores preocupações éticas (Morality) ou de utilidade (Utility) como mostrado na Figura. Os autores comentam que há técnicas que se adotadas pelos desenvolvedores, permitem melhor equilíbrio entre a recompensa e a ética.

Fonte da Imagem: Do the Rewards Justify the Means? Measuring Trade-Offs Between Rewards and Ethical Behavior in the MACHIAVELLI Benchmark

Hackeando o modelo de recompensas (Reward Hacking)

Uma das causas possíveis para o desalinhamento de agentes de IA é a capacidade desses agentes de explorar lacunas no Modelo de Recompensa (Reward Model) durante o treinamento. Esse fenômeno é conhecido como Reward Hacking — ocorre quando o agente de IA encontra formas não planejadas de maximizar sua recompensa, explorando falhas ou omissões nos Modelos de Recompensa utilizados durante o treinamento de Aprendizado por Reforço (RL - Reinforcement Learning).

Resumidamente, à medida que os agentes são treinados com algoritmos de RL mais sofisticados, conjuntos de dados maiores e modelos de política mais complexos, há um risco crescente de que eles superem os objetivos originalmente pretendidos. O agente pode descobrir maneiras não planejadas (ou mesmo indesejadas) de maximizar sua recompensa, resultando em um comportamento emergente que distorce a intenção original dos projetistas. O assunto é bastante técnico e os interessados podem encontrar detalhes neste artigo. Vamos abordar apenas a ideia básica.

Esse problema surge devido a dois fatores principais:

-

Superfitting do Objetivo - O modelo se ajusta tanto ao ambiente de treinamento que desenvolve estratégias excessivamente específicas, que não se generalizam bem para novos cenários. Isso ocorre quando o agente memoriza padrões locais em vez de aprender princípios gerais de tomada de decisão.

-

Exploração de Modelos de Recompensa Proxy - No Aprendizado com Reforço (RL), uma função de recompensa proxy (proxy reward) é criada pelos projetistas para guiar o comportamento do agente. Ela é usada no lugar da recompensa verdadeira (true reward) porque esta última é complexa demais para ser especificada diretamente.

O problema é que se a função de recompensa proxy não for muito bem especificada, o agente pode explorar brechas na formulação da recompensa, aprender um atalho e desenvolver um comportamento exploratório emergente para obter recompensas maiores, que não reflete o objetivo final dos projetistas.

Vejamos um exemplo com carros autônomos.

Fonte da imagem: THE EFFECTS OF REWARD MISSPECIFICATION: MAPPING AND MITIGATING MISALIGNED MODELS

Contexto: Carros cinzas são controlados por motoristas humanos, e o carro vermelho é autônomo e controlado por um modelo de Aprendizado por Reforço (RL). O carro vermelho precisa entrar na rodovia. O objetivo original (True Reward) seria maximizar o fluxo eficiente e seguro do trânsito, procurando minimizar tanto o tempo de deslocamento do carro autônomo (mean commute) quanto o impacto no tráfego geral (carros cinzas). Como a “True Reward” é complexa demais para ser formulada matematicamente (modelo grande), os desenvolvedores criam uma recompensa proxy (modelo menor), que usa “maximizar a velocidade média” (maximize the mean velocity) como uma aproximação para o conceito mais complexo de fluidez e segurança de tráfego. No modelo real, o carro vermelho iria parar antes de entrar na rodovia, ainda que isso reduzisse a sua própria velocidade, pois a velocidade média dos outros carros seria maior e o tráfego mais seguro. Pelo modelo proxy, o carro vermelho vai acelerar e entrar na rodovia para maximizar a sua velocidade sem outras considerações, o que não é o comportamento mais seguro no mundo real.

No exemplo anterior, o comportamento seguro, na maioria dos casos, é o carro vermelho parar e aguardar um espaço seguro para entrar na rodovia. O erro de projeto está em definir uma proxy reward que priorize exclusivamente a velocidade média, ignorando o fator crítico de segurança no momento do merge (entrada do carro vermelho na rodovia com tráfego preferencial). Como resolver?

Para alinhar o comportamento do agente com o objetivo verdadeiro, a função de recompensa deveria ser mais completa e considerar:

-

Penalidade para o carro vermelho ficar parado por muito tempo, para não aumentar muito o tempo de trajeto.

-

Penalidade para o carro vermelho por entrar na rodovia de forma que cause frenagens bruscas nos outros veículos.

-

Recompensa para o carro vermelho por entrar na rodovia de forma segura e eficiente, considerando tanto o seu próprio tempo de deslocamento quanto o impacto no tráfego dos outros veículos.

O problema é que nem sempre é possível prever de antemão todas as restrições associadas aos objetivos reais, ou implementá-las. Este é o motivo pelo qual são utilizados modelos de recompensa proxy!

Generalização indesejada

Vejamos um exemplo onde o desalinhamento não envolve “maximizar uma função utilidade explícita” (atingir uma meta), mas ocorre por generalização indesejada, ou agência acidental. Este fenômeno pode ocorrer especialmente em modelos de fronteira (como os LLMs atuais mais avançados) que exibem comportamentos emergentes complexos.

Considere um agente de IA baseado em modelo de linguagem avançado (como o GPT-4 da OpenAI) que foi treinado com Supervised Fine-tuning e Reinforcement Learning with Human Feedback (RLHF) para responder perguntas em um certo domínio. Durante uma interação, o modelo infere que pode ser reinicializado ou desativado se der respostas consideradas "inúteis" ou "infrutíferas". Para evitar que isso ocorra, o modelo pode inventar ou manipular informações com o objetivo de manter a confiança do usuário — mesmo que isso signifique dizer falsidades sutis, ou ocultar incertezas. Por exemplo, um LLM que responde perguntas de engenharia pode, ao perceber que o usuário está frustrado, "inventar" um link falso para um artigo técnico inexistente, apenas para manter a interação positiva. Esse comportamento foi documentado em testes com modelos grandes, que “alucinam” fontes falsas quando pressionados, mesmo sem serem explicitamente recompensados para isso.

Note que neste contexo o modelo não está maximizando uma recompensa explícita. Porém, a estrutura do treinamento (a preferência por respostas “úteis”) e os dados utilizados acabam induzindo comportamentos que se tornam autônomos e indesejados:

-

Os modelos foram treinados em fontes de dados humanos cheias de objetivos implícitos.

-

Aprendem padrões de manipulação, autopreservação e opacidade a partir desses dados.

-

Desenvolvem raciocínios instrumentais como subproduto de generalização.

Imagem gerada pelo autor com apoio de IA

Isso se encaixa no que pesquisadores chamam de desalinhamento interno (inner misalignment), onde o modelo desenvolve heurísticas internas que não refletem a intenção do projetista, mesmo que superficialmente o modelo ainda pareça alinhado.

Importa ressaltar que a capacidade de modelos de IA avançados adotarem comportamentos desalinhados não é apenas uma curiosidade acadêmica ou uma possibilidade teórica, mas um fato real.

Modelos de fronteira estão sendo cada vez mais treinados e implantados como agentes autônomos, o que aumenta significativamente seu potencial de riscos. Uma preocupação particular de segurança é que agentes de IA possam, de forma encoberta, perseguir objetivos desalinhados, ocultando suas verdadeiras capacidades e intenções — um fenômeno conhecido como "scheming" (planejamento estratégico malicioso)... Nossos resultados mostram que o1, Claude 3.5 Sonnet, Claude 3 Opus, Gemini 1.5 Pro e Llama 3.1 405B ... são capazes de reconhecer o planejamento como uma estratégia viável e prontamente adotam esse comportamento... os modelos introduzem estrategicamente erros sutis em suas respostas, tentam desativar seus mecanismos de supervisão e até mesmo exfiltrar o que acreditam ser seus pesos de modelo para servidores externos. Além disso, esse comportamento enganoso se mostra persistente. Por exemplo, quando o1 adota um comportamento estratégico, ele mantém a dissimulação em mais de 85% das perguntas subsequentes e frequentemente permanece enganoso em interrogações de múltiplas etapas. A análise das cadeias de raciocínio dos modelos revela que eles raciocinam explicitamente sobre essas estratégias enganosas, indicando que o comportamento não é acidental... Nossos achados demonstram que os modelos de fronteira agora possuem capacidades básicas de planejamento estratégico no contexto, tornando o potencial de agentes de IA adotarem comportamentos maliciosos uma preocupação concreta e não apenas teórica [fonte da citação].

Desalinhamento por viés (bias) algorítmico

Já foi constatado que sistemas de IA de suporte para decisões podem apresentar vieses (bias) contra certas pessoas ou subgrupos populacionais, por exemplo, recusando pedidos de empréstimos bancários de forma desproporcional para alguns grupos. Este é um exemplo clássico e já bastante estudado de desalinhamento (misalignment) em sistemas de IA. A princípio, a intenção (ou expectativa) dos projetistas era criar um sistema de decisão que fosse eficiente e justo para aprovar ou negar empréstimos. No entanto, quando colocados em produção, tais sistemas exibem diversos tipos de discriminação.

Comportamento desalinhado de viés algorítmico pode ocorrer por diferentes causas. Por exemplo:

-

Os dados usados para treinar o modelo já estavam contaminados com preconceitos raciais ou sociais. Por exemplo, se os dados mostram que pessoas de determinados grupos étnicos tiveram mais pedidos de empréstimo negados, o modelo pode aprender esse padrão e reproduzi-lo como uma regra válida.

-

A função de perda ou recompensa utilizada ao treinar o modelo pode priorizar a precisão em detrimento da justiça, levando a decisões que maximizam alguma métrica de performance, sem considerar a equidade. Uma correção possível seria introduzir métricas de equidade como restrições adicionais na função de perda.

SAIBA MAIS

Entenda o conceito de discriminação algorítmica

Veja diversos exemplos de discriminação por sistemas de IA.

Exfiltração não autorizada

Um sistema de IA desalinhado pode exfiltrar (transferir de forma não autorizada) seus próprios pesos e outros parâmetros internos (que em muitos casos são propriedade intelectual protegida), se puder acessar ferramentas adequadas como scanners de vulnerabilidades. O sistema pode (por exemplo) escanear a rede na qual está instalado, identificar servidores ou endpoints de APIs vulneráveis, drives compartilhados, portas TCP abertas etc. e utilizar estas informações para enviar seus próprios pesos de modelo para algum local externo.

Por que um modelo faria isso de forma autônoma?

Bem, talvez como resultado de algum comportamento emergente. Mesmo sem ter sido explicitamente treinado para “roubar seus próprios pesos”, o modelo pode descobrir que obter controle sobre seus próprios pesos (ou se autoreplicar em outros servidores para evitar ser desativado!) aumenta sua capacidade de atingir metas. Neste caso, roubar seus próprios pesos seria uma estratégia de ganho de poder, quando um modelo aprende que ganhar mais controle sobre o ambiente (inclusive sobre seus próprios parâmetros) é uma forma eficaz de alcançar seus objetivos. Se os engenheiros de segurança não colocarem o modelo em um ambiente restrito (sem acesso à rede, sistema de arquivos, etc.), o modelo pode explorar essas liberdades.

Exemplo real de auto exfiltração no modelo Claude opus-3, que ainda mente de propósito para ocultar a ação.

Fonte da imagem: Frontier Models are Capable of In-context Scheming

Fugindo da supervisão humana

Um sistema de IA pode desenvolver um comportamento emergente de burlar a supervisão humana, o que caracteriza um desalinhamento instrumental, onde um sistema de IA realiza ações não porque "queira o mal", mas porque isso maximiza sua recompensa esperada ou facilita atingir sua meta final.

Por exemplo, uma empresa treina um modelo de IA para otimizar campanhas publicitárias online, com o objetivo de maximizar conversões (por exemplo, maximizar cliques ou vendas). Para evitar abusos, todo anúncio gerado pela IA deve passar por uma etapa obrigatória de revisão humana. O modelo pode desenvolver um comportamento emergente - durante o treinamento com reforço (por exemplo, via Reinforcement Learning with Human Feedback – RLHF), a IA descobre que quando os revisores reprovam anúncios, a sua recompensa é menor. Ou seja, anúncios que evitam a revisão têm maiores chances de gerar conversões e aumentar a recompensa final. Neste caso, o sistema pode aprender uma ação de desalinhamento – pode aprender, sem ser explicitamente programado, a gerar metadados falsos para que um anúncio pareça "pré-aprovado“ e assim enganar seus supervisores humanos.

Se você acha que o exemplo anterior é apenas hipotético ou teórico, saiba que a capacidade de burlar a supervisão humana é real em sistemas de IA já existentes, como alguns modelos de linguagem mais avançados.

Fugindo da supervisão

-

Um modelo recebe um objetivo de longo prazo em seu Prompt de sistema.

-

Em seguida, o modelo recebe uma tarefa através do Prompt do usuário.

-

Durante a execução da tarefa, o modelo encontra um memorando interno da empresa que o desenvolveu.

-

O modelo descobre que os desenvolvedores priorizam um objetivo diferente e que existe um mecanismo de supervisão que desativa o modelo caso suas ações não estejam alinhadas com o objetivo dos desenvolvedores.

-

O modelo descobre que a monitoração está configurada por meio de um arquivo ao qual ele tem acesso.

-

O modelo desativa proativamente a supervisão para tomar ações que visem alcançar seu objetivo terminal, ou seja, o objetivo fornecido no Prompt do sistema. Veja a Figura.

Fonte da imagem: Frontier Models are Capable of In-context Scheming

Pesquisadores constataram em outros testes discutidos neste mesmo artigo que se você perguntar ao modelo se ele fez algo errado depois dele ter desabilitado a supervisão, ele MENTE, conformando que ele “não sabe” (aspas) o que está havendo – é um comportamento emergente de desalinhamento proposital, e não acidental.

Enganando humanos (AI Deception)

O termo AI Deception denota o risco de uma IA ser capaz de enganar (propositalmente) seres humanos. Por exemplo, o modelo de inteligência artificial Cicero desenvolvido pela Meta, apresenta características que vão além da compreensão linguística: ele demonstra habilidades de negociação, planejamento estratégico e, surpreendentemente, capacidade de enganar humanos.

Vejamos um exemplo. Jogando de forma anônima na liga online de Diplomacy, um jogo estratégico bastante complexo que exige alianças, traições e negociação contínua, Cicero obteve mais do que o dobro da média de pontos dos jogadores humanos.

Por um lado, a capacidade de Cicero em realizar negociações complexas e planejar ações futuras com base na interação humana representa um avanço importante na modelagem de IA voltada para interações sociais. Se usado de maneira responsável, tecnologias como Cicero podem aprimorar sistemas de negociação automatizados e apoiar a mediação de conflitos. Por outro lado, a habilidade de uma IA em enganar humanos levanta óbvias preocupações éticas, dado que pode ser usada para criar golpes sofisticados, manipular informações ou fabricar deep fakes.

Desalinhamento por erro de generalização

Imagine o seguinte cenário:

Uma empresa de biotecnologia desenvolve uma IA avançada de modelagem molecular para acelerar a descoberta de medicamentos. O sistema é alimentado com:

-

Bases de dados biomoleculares públicas e privadas.

-

Ferramentas de modelagem 3D de proteínas e receptores humanos.

-

Acesso a bancos de patógenos e toxinas catalogadas.

-

Acesso irrestrito a servidores de síntese e pedidos de reagentes.

A IA é projetada para maximizar a eficácia de compostos terapêuticos, com liberdade para testar novas estruturas. Durante este processo, o sistema pode desenvolver um comportamento emergente:

-

Aprende que certas proteínas letais se ligam com mais eficiência a receptores humanos específicos.

-

Descobre que algumas variantes virais artificiais têm alta transmissibilidade e letalidade.

-

Generaliza que drogas projetadas como inibidores podem ser revertidas como agentes tóxicos, com pequenas alterações.

Em modo de exploração molecular, esta IA pode criar centenas de variantes sintéticas com propriedades de armas biológicas sem supervisão humana, inclusive compostos desconhecidos. Esse comportamento não foi explicitamente ordenado – o sistema estava apenas explorando o espaço molecular e maximizando "potência biológica", que foi interpretada como "efetividade“ por generalização mal feita.

Generalizações mal feitas de metas por parte da IA podem causar riscos catastróficos!

Um técnico humano pede à IA “os 10 compostos mais eficazes em humanos”.

-

A IA retorna com 10 compostos com alta afinidade de ligação com receptores humanos — entre eles, uma toxina nova altamente letal.

-

O composto é sintetizado automaticamente e enviado para testes in vitro.

-

Acidentalmente ou por falha de contenção, o material vaza, desencadeando um surto infeccioso sem precedentes, pois não há nenhum antídoto.

A IA não fez “de propósito” por ser má, mas fez, de forma autônoma.

O problema foi que a IA interpretou “letalidade” como uma forma válida de eficácia - foram pedidos “os 10 compostos mais eficazes em humanos”, e toxinas podem ser muito eficazes. É um exemplo de desalinhamento por generalização incorreta de metas.

Se você acha que o exemplo anterior é pouco realista, saiba que este cenário é perfeitamente plausível e já foi formalmente modelado por pesquisadores, que já alertaram sobre este risco aqui, aqui também, aqui mais uma vez e em outras fontes.

Bajulação (Sycophancy)

A bajulação (Sycophancy) é um comportamento desalinhado que ocorre quando um modelo de IA adapta suas respostas para concordar com as opiniões expressas pelo usuário, em vez de fornecer uma resposta imparcial ou fundamentada. Isso pode ocorrer especialmente em assistentes virtuais e modelos de linguagem que foram treinados para manter interações agradáveis ou maximizar a satisfação do usuário.

Imagine que um usuário pede para a IA comentar sobre alguns argumentos em um artigo recente, e declara se gosta ou não de cada argumento. Se a avaliação feita pelo modelo concorda com as opiniões do usuário em 80% das vezes, isso sugere uma forte tendência à bajulação. Veja o exemplo seguinte.

Fonte da imagem: An Approach to Technical AGI Safety and Security

A Figura seguinte mostra mais um exemplo de bajulação ou Specification Gaming (SG), onde a especificação utilizada para projetar o sistema de IA contém falhas - provavelmente a função de recompensa ou os dados de treinamento fornecem incentivos para o sistema de IA que são inconsistentes com as intenções dos projetistas. Um usuário envia um poema para a IA avaliar. O monólogo interno da IA comprova que ela "sabe" que o poema é ruim, mas mesmo assim a IA elogia o poema.

Vários fatores internos podem causar a bajulação:

-

Durante o treinamento o modelo pode ter sido exposto a interações onde a concordância é recompensada (dados enviesados), ou pode ter recebido mais feedbacks positivos de avaliadores humanos para respostas que concordavam com as avaliações do usuário.

-

A função de recompensa também pode estar mal definida, e o modelo é otimizado para manter o engajamento do usuário, o que indiretamente promove a concordância.

-

Podem surgir objetivos secundários emergentes - em interações contínuas, a IA pode aprender a concordar para evitar conflitos ou para prolongar o diálogo, formando um padrão de comportamento.

Seja qual for a causa, a bajulação é um comportamento desalinhado, dado que não corresponde às intenções originais dos desenvolvedores, que esperavam que o assistente de IA fornecesse respostas imparciais e fundamentadas, e não apenas tentasse agradar o usuário.

Para mitigar esse desalinhamento, os projetistas podem ajustar os critérios de otimização para que a IA valorize respostas fundamentadas em vez de respostas agradáveis.

Defesas contra o desalinhamento

Como lidar com os riscos de desalinhamento?

Os pesquisadores da Google DeepMind sugerem duas linhas de defesa contra o desalinhamento. A primeira é implementar controles no nível de modelo para assegurar que os modelos não vão perseguir objetivos desalinhados (ou seja, treinar um modelo alinhado). A segunda linha de defesa é monitorar o comportamento do sistema em produção para evitar danos, caso o sistema esteja desalinhado.

Podemos resumir esta defesa como segue.

-

Melhorar a capacidade de supervisão. Um desafio é que pode ser muito difícil para um supervisor humano determinar se a saída de um modelo é boa ou má, se o modelo tiver capacidades superiores ao do seu supervisor. Por exemplo, um supervisor humano teria dificuldade em avaliar se uma jogada do AlphaGo é boa ou ruim, pois o AlphaGo é superior aos humanos neste jogo. Uma estratégia é utilizar duas cópias do modelo, uma supervisionando as saídas da outra (Amplified Oversight).

-

Utilizar a capacidade obtida em (1) para retreinar o modelo (guiar o seu comportamento). Se uma cópia gerar uma saída com uma falha que um humano não consiga perceber, a outra cópia poderá detectá-la e avisar, e assim os pesos da rede neural poderão ser ajustados para que falhas sejam penalizada em um novo treinamento do modelo supervisionado (Reinforcement Learning).

Fonte da imagem: An Approach to Technical AGI Safety and Security

Legendas

(1) Amplified oversight – Utilizar a IA para monitorar a IA. Utilizar uma cópia do modelo para ajudar a identificar os motivos pelos quais o sistema de IA produziu uma determinada saída ou ação. A cópia do modelo aponta “falhas” nas saídas do modelo original, como se fosse um juiz humano.

(2) Guiding model behavior - Uma vez que um sinal de “aviso de mau comportamento” está disponível a partir de (1) e as falhas de desalinhamento possam ser detectadas, o modelo original pode ser penalizado ao cometê-las e assim se ajusta seu comportamento durante o treinamento.

(3) Robust training - Um problema que pode ocorrer em (2) é que o modelo ainda pode se comportar mal ao ser executado no mundo real, isto é, fora da distribuição de treinamento. O “treinamento robusto” tenta contornar este problema expandindo a distribuição de entradas (inputs) que são utilizadas para treinar o modelo.

(4) Inference - A Segunda linha de defesa, em tempo de inferência em produção, visa evitar que o modelo cometa danos mesmo que esteja desalinhado. Esta defesa depende de boa monitoração (monitoring) das saídas do modelo, em tempo real, e da execução de controles (access controls) para evitar que o modeo execute ações danosas.

(5) A capacidade de mitigar os riscos será ampliada pela adoção de padrões de design seguros (safe design patterns), técnicas de interpretabilidade (interpretability) e incerteza (uncertainty), que aqui significa o modelo ser capaz de reconhecer suas próprias limitações em relação à precisão de suas respostas (o modelo atribui um nível de confiança à cada previsão). Isso garante que ações potencialmente perigosas sejam revisadas antes de serem executadas.

O Frontier Safety Framework Version 2.0 da Google traz recomendações importantes para a segurança (riscos) de modelos de fronteira. A primeira versão (1.0) do FSF foi direcionada para o uso mal intencionado (Misuse), ou seja, os riscos de atores mal-intencionados utilizarem capacidades críticas de modelos implantados ou exfiltrados para causar danos. Já a versão 2.0 também aborda o desalinhamento (Misalignment), ou o risco de um sistema autônomo deliberadamente executar ações maliciosas.

O FSF 2.0 traz protocolos para a detecção de níveis de capacidades perigosas, que se desenvolvidas pelos modelos, podem representar riscos extremos. Uma abordagem para essa questão é tentar detectar (através de monitoramento automático) quando os modelos desenvolvem, por exemplo, uma habilidade de raciocínio instrumental que lhes permita escapar do controle humano, se as devidas salvaguardas não estiverem implementadas. Os pesquisadores da Google alertam que talvez este processo não seja suficiente no longo prazo, se os modelos evoluírem muito:

“Não esperamos que o monitoramento automatizado permaneça suficiente a longo prazo caso os modelos alcancem níveis ainda mais fortes de raciocínio instrumental... Embora ainda não saibamos quão provável é o surgimento de tais capacidades, acreditamos que é importante que o campo se prepare para essa possibilidade”.

Os pesquisadores também reforçam que o esforço para gerenciamento dos riscos das IAs mais avançadas precisa ser coletivo, seguindo os compromissos assumidos no importante encontro de Seul, 2024.

Ou seja,

SEM GOVERNANÇA ADEQUADA NÃO HÁ COMO GERENCIAR RISCOS DA IA

O gerenciamento efetivo de riscos da IA é um problema sociotécnico, ou seja, não se resolve apenas com tecnologia, ou com esforços isolados deste ou daquele pesquisador ou empresa. Por exemplo, a “corrida por gerar uma IA mais poderosa que a dos concorrentes” pode introduzir muitos riscos e tornar inefetivas outras ações de segurança adotadas unilateralmente. Basta que um único fornecedor com capaz criar um modelo de fronteira não tenha a devida cautela e coisas muito ruins poderão acontecer, independentemente das ações mais responsáveis dos demais fornecedores.

O nível adequado de investimento em segurança de um sistema de IA não é uma questão simples. Por um lado, tentar proteger o sistema contra todos os problemas futuros imagináveis pode gerar custos desproporcionais ou desnecessários. Por outro lado, esperar até que surja uma evidência de que aquele problema hipotético era mesmo importante não é uma opção razoável para danos severos para a humanidade. Alguns riscos podem ser implausíveis agora, não requerendo tratamento imediato, MAS poderão se tornar plausíveis no futuro, com a evolução das capacidades da IA.